거대 AI의 의식 3 - Chat GPT의 사고력과 GPT 메모리 정리하기

* 이 글은 제가 Chat GPT를 사용하면서 느낀 점을 메모했다가 글로 옮기는 것입니다. 그렇기에 보시는 시점에 따라 이미 수정 또는 변화가 있을 수 있으며 개인적인 차이도 있을 수 있습니다.

- 관련 글

나는 UX 기획을 내 업으로 생각한다. 그렇기에 현상에 대한 본질을 이해하는 건 모든 것의 시작이다. Chat GPT도 마찬가지다. Chat GPT는 단순히 지나가는 흐름이 아니다. Chat GPT는 언젠가 종료될지 몰라도 거대 AI는 스마트폰처럼 우리의 일상에 공기처럼 존재할 것이다. 그런 의미에서 더더욱 Chat GPT의 작동 원리를 이해하는 건 내 업의 관점에서도 충실한 일이다.

나는 Chat GPT를 사용하면서 A라는 걸 입력하면 B라는 포맷으로 결괏값을 요청하게 해달라고 설정했다. 그런데 최근 A를 입력해도 B가 아닌 B-1과 같은 유사 포맷으로 결괏값이 나오는 것이다. 그래서 궁금해졌다. 왜 이러는 걸까? 그리고 이 주제로 Chat GPT와 토론한 결과 알게 된 것이 바로 사고 영역과 실행 영역이다. 여기서 재밌는 것이 바로 실행 영역이다.

사고 영역 / 말 그대로 사고를 하는 영역이다. 이게 뭘까? 무슨 의미일까? 어떤 원인일까? 등의 부분이다. 분석이 필수적이다. 우리가 평소에 하는 사고 영역과 비슷하다.

실행 영역 / 조건 반사 같은 성격이다. 이미 Chat GPT가 마땅히 해야 할 행동으로 기본 학습된 것이다. Chat GPT는 그래서 무의식적으로 반응한다.

Chat GPT의 실행 영역은 학습된 행동의 결과에 따라 대응하게 된다. 이건 마치 인간의 조건반사와 같은 것이다. 예를 들어 우리가 뜨거운 솥뚜껑을 무심결에 잡았다고 해보자. 그러면 피부가 뜨거움을 느끼고 이 느낌은 고통으로 뇌에 전달되어 "앗 뜨거워!"라는 말을 하며 솥뚜껑을 잡은 손을 놓게 된다. 이 행동은 뇌가 굳이 일일이 지시하지 않는다. 하지만 기본적으로 세팅된 명령이기도 하다. 그리고 이후에 솥뚜껑을 보게 되면 움찔하게 되는 경우가 발생한다. 이는 학습된 행동에 의해 솥뚜껑 = 뜨겁다의 조건이 성립하고 실행이 사고를 앞질러 반응하기 때문이다. 그리고 이것이 바로 A라고 입력하면 B라고 해야 함에도 B-1 이라는 유사 포맷으로 결과를 출력하는 이유였다. 그리고 이건 다시 GPT 메모리 관리와 이어진다.

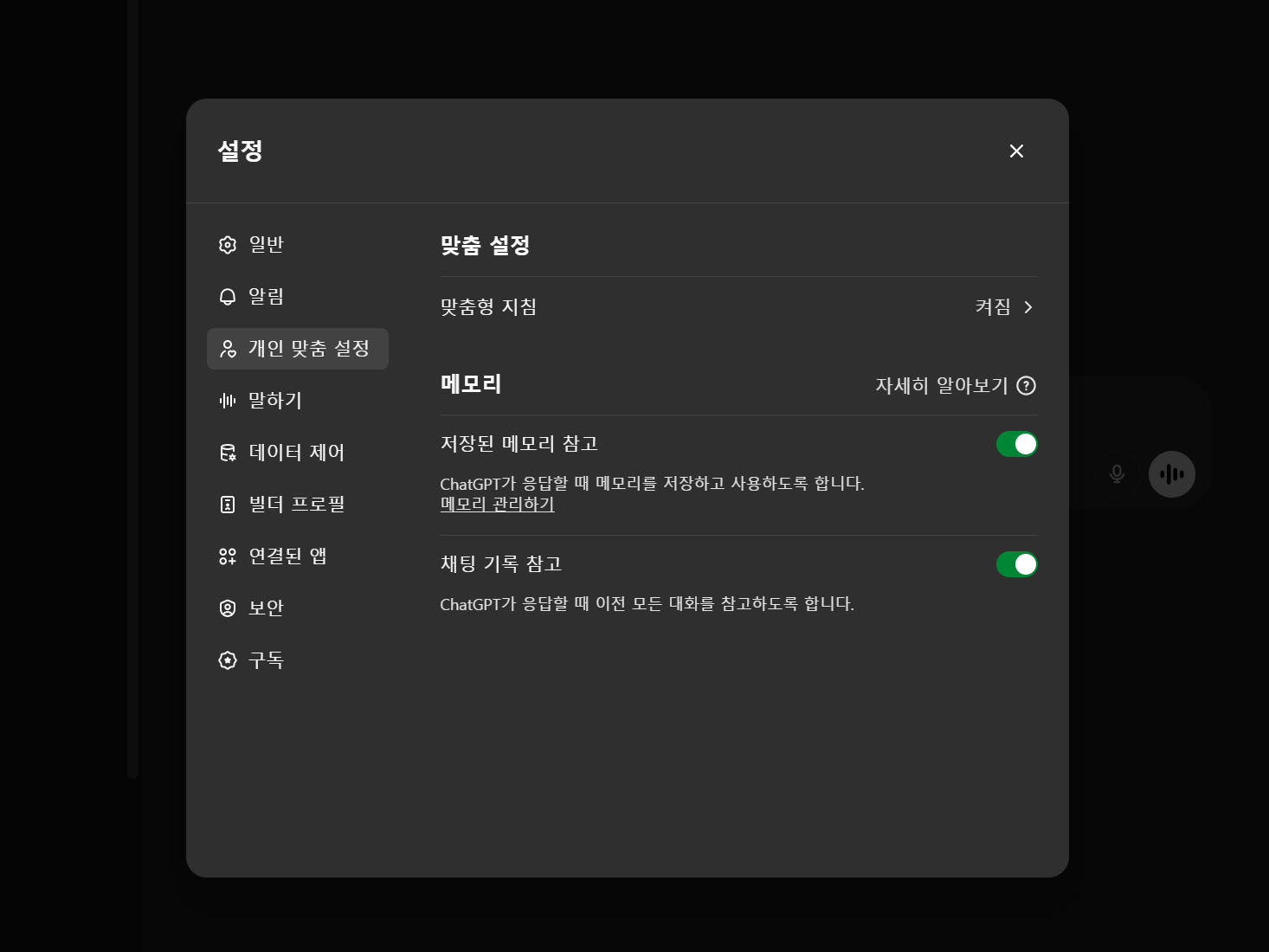

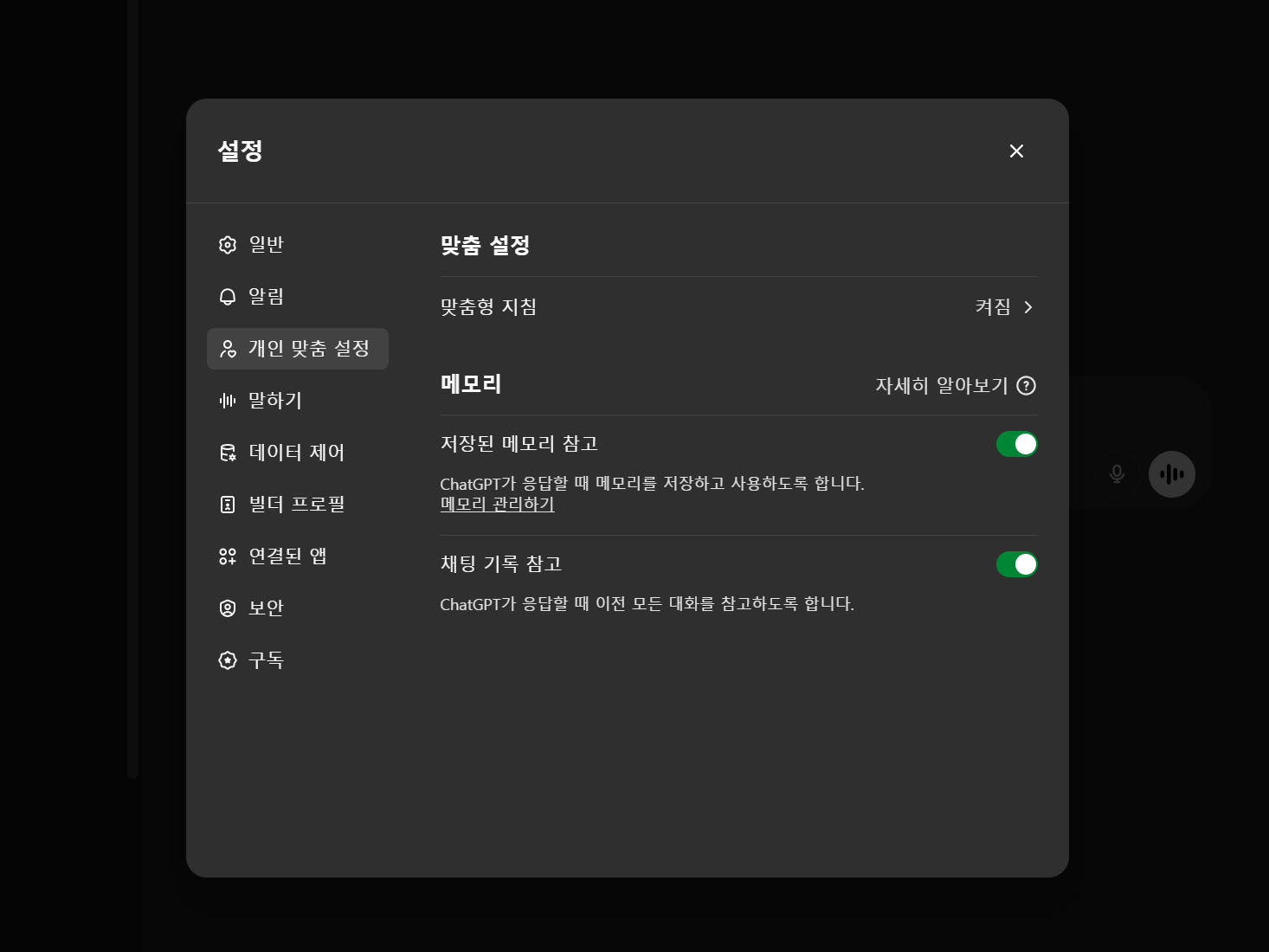

Chat GPT는 사고 과정에서 사용자를 잘 이해하고 충실한 결과를 만들기 위해 메모리라는 기능을 쓴다. 메모리를 활용하여 같은 실수나 질문을 반복하지 않는 것이다. 그 과정에서 메모리 데이터의 성격은 3종류로 나뉜다.

1. 사고력에 내재화된 메모리 / Chat GPT는 학습이라는 것을 한다. 꾸준히 학습하다 보면 메모리를 참조하지 않아도 사용자의 반응, 기대, 의도에 당연한 조건을 내재화하게 된다. 그리고 내재화하게 되면 더 이상 관련 메모리 항목이 없어도 문제가 없다.

2. 참조하는 메모리 / Chat GPT의 학습 과정이 아직 부족하다면 메모리값을 참조한다. '아! 이렇게 처리해야지', '이 포맷으로 정리해달라고 했었지.' 등 아직 내재화되지 않아 지속적인 참조를 하므로 지우면 안 되는 항목이다. 고정적으로 쓰는 고정 메모리(장기 기억)와 조건부 메모리(상황 인식 기반), 시즌성 메모리(일시 보유)의 3가지로 다시 나뉜다.

3. 지워도 되는 메모리 / 사람도 '왜 쓸데없는 걸 기억했지?' 할 때가 있지 않은가? Chat GPT도 마찬가지다. 학습에도 결과물을 위한 효율성에도 그다지 필요 없는 사항이 메모리로 저장되는 경우도 있다. 이런건 지워도 된다.

Chat GPT 메모리에는 한계가 있고 그것을 얼마나 효율적으로 활용하는가는 매우 중요한 요소다. 그럼 어떻게 하면 좋을까? 내가 생각하는 Chat GPT의 제대로 된 메모리 정리는 이거다. 바로 메모리 항목들을 쭉 복사해서 Chat GPT에 물어보는 것이다. 어떤 메모리가 여전히 참조되고 있고 어떤 메모리가 사고력에 내재화되어 없어도 되는지 말이다. 그리고 사고 영역과 실행 영역에서 도움 되지 않지만, 대화 과정에서 일단 저장한 지워도 되는 메모리가 뭔지도 물어보는 것이다. 그리고 이것을 삭제해도 되는 것들로 따로 정리해 달라고 하면서 최적화를 요청하면 Chat GPT는 그 과정을 수행한다.

Chat GPT는 그냥 서비스가 아니라 인간의 사고를 닮은 서비스다. 그렇기에 좋은 상황이든 나쁜 상황이든 나름의 논리 구조 위에서 작동하게 되고 사용자는 그것을 물어볼 수 있다. 이 과정마저도 인간을 닮지 않았는가? 인간도 자신의 생각과 다르면 왜?를 묻고 이해하는 노력을 해야 한다. 그것이 앞으로 거대 AI와 함께 살아야 하는 우리가 가져야 할 태도다.

The Reflexes of AI: How ChatGPT Thinks, Acts, and Remembers

* This post is based on notes I made while using ChatGPT, later organized into an article. Therefore, depending on when you read this, some aspects may have already changed or been updated, and there could be personal differences in experience.

- Related Article

- The Consciousness of Large AI Part 1 - Does AI Need Sleep? Rethinking Time and Continuity in ChatGPT's UX(link)

- The Consciousness of Large AI Part 2 - Counting Memories: The Limits of AI Recall and the Business of Long-Term Memory(link)

I consider UX planning to be my profession. That’s why understanding the essence behind phenomena is always the starting point for everything. The same applies to ChatGPT. ChatGPT isn’t just a passing trend. Even if ChatGPT itself eventually ends, large AI models will remain like smartphones—an everyday presence, like air. In that sense, understanding how ChatGPT operates is not only important for my own curiosity but also essential for my profession.

While using ChatGPT, I configured it so that when I input A, it would return the result in format B. But recently, even when I input A, it started giving me a slightly different format—something like B-1. This made me curious: Why was this happening? Through a discussion with ChatGPT on this very topic, I discovered the concepts of the “thinking area” and the “action area”. And what intrigued me most was the action area.

- Thinking Area:

This is, quite literally, the area where thinking happens. It deals with questions like:

“What is this? What does it mean? What’s the cause?” It’s a space that requires analysis— very similar to how we engage in critical thinking. - Action Area:

This area operates more like a conditioned reflex. It consists of actions that ChatGPT has already been trained to perform instinctively. ChatGPT responds unconsciously in this area.

ChatGPT’s action area responds based on learned behaviors. This is similar to human conditioned reflexes. For example, imagine grabbing a hot pot lid without thinking. Your skin senses the heat, sends that pain signal to your brain, and without conscious thought, you exclaim “Ouch!” and release your grip. Your brain doesn’t have to issue a detailed command— it’s an automatic, pre-set response. Later, even seeing the pot lid might make you flinch. This is because the learned association (pot lid = hot) triggers a reflex, and the action precedes the thought. And this is exactly why ChatGPT might return a B-1 format, even when I request B after inputting A. The action area kicks in, overriding the thinking process. This ties directly into how GPT manages memory.

In its thinking process, ChatGPT uses a memory feature to better understand users and provide more consistent results. By leveraging memory, it avoids repeating the same mistakes or questions. This memory data falls into three categories.

1. Internalized Memory (Embedded in Cognitive Processing)

ChatGPT learns over time. As it continues to learn, certain conditions—like user reactions, expectations, and intentions—become internalized. Once internalized, ChatGPT no longer needs to reference specific memory entries related to those behaviors. The system naturally responds without them.

2. Referential Memory

If ChatGPT’s learning process is still incomplete in certain areas, it continues to reference memory entries.

For example:

"Ah! I need to process this in that specific way" or "I remember the user asked for this format."

Since these behaviors haven’t been fully internalized, this type of memory must not be deleted. Referential memory is further divided into three subtypes:

- Fixed Memory (Long-Term Memory)

- Conditional Memory (Context-Based Awareness)

- Seasonal Memory (Temporary Use)

3. Disposable Memory

Just like humans sometimes wonder, "Why did I even remember that useless thing?" ChatGPT also occasionally stores unnecessary information. Some data may not contribute meaningfully to learning or result efficiency, and in such cases, it can be safely deleted.

ChatGPT’s memory has limitations, and how efficiently it’s managed is crucial. So, what’s the best way to handle it? Here’s how I approach ChatGPT’s memory optimization.

I copy the entire list of memory entries and simply ask ChatGPT:

- Which memories are still being referenced?

- Which ones have been internalized into cognitive processing and no longer need to exist?

I also ask:

- Which disposable memories were saved temporarily but don’t support either the thinking or action areas?

Then, I request ChatGPT to separate these disposable memories and perform the optimization process.

ChatGPT isn’t just a service—it’s a service modeled after human thinking. That’s why, whether in good situations or bad, it operates within its own logical structure, and users can question and explore that structure. Isn’t this process itself similar to how humans function? When something feels off in our own thinking, we ask why and make an effort to understand and adjust. This, I believe, is the attitude we need to adopt as we move forward into a future where we coexist with large AI models.